RAKsmart作为高性能服务器提供商,其硬件配置和网络环境非常适合运行AI大模型。下面,AI部落小编为您讲解如何在RAKsmart服务器上部署DeepSeek AI大模型的完整流程。

️一、部署前的准备工作

1.服务器选型与配置

DeepSeek等AI大模型对计算资源要求较高,建议选择RAKsmart以下配置的服务器:

GPU型号:至少配备NVIDIATeslaV100或A100显卡(显存16GB以上),多卡并行可提升训练/推理速度。

内存:64GB及以上,避免因内存不足导致进程崩溃。

存储:1TBNVMeSSD,确保模型文件(通常数百GB)快速加载。

操作系统:Ubuntu22.04LTS或CentOS8,兼容主流深度学习框架。

2.系统环境初始化

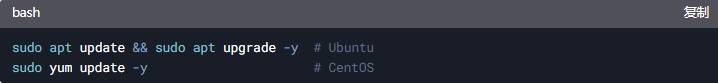

更新系统:

aspcms.cn 安装基础工具:

️二、安装深度学习环境

1.配置NVIDIA驱动与CUDA

安装显卡驱动:

访问NVIDIA驱动下载页,选择对应GPU型号的驱动。

安装CUDAToolkit。

DeepSeek依赖CUDA加速,推荐CUDA11.8。

添加环境变量至~/.bashrc。

2.安装PyTorch与依赖库

使用pip安装适配CUDA11.8的PyTorch。

安装模型运行依赖。

️三、下载与配置DeepSeek模型

1.获取模型权重

官方渠道:

若已获得DeepSeek官方授权,可通过提供的链接下载模型文件(通常为.bin或.safetensors格式)。

HuggingFaceHub:

若模型已开源,使用git-lfs克隆仓库。

2.模型配置文件调整

修改config.json以适配硬件:

️四、启动模型推理服务

1.编写推理脚本

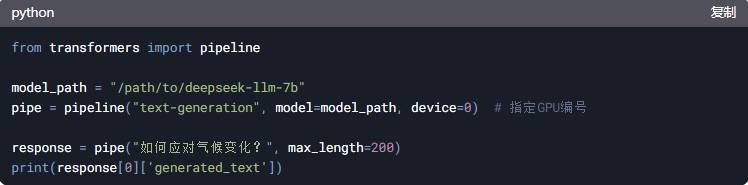

创建inference.py,使用HuggingFace的pipeline快速调用:

2.运行测试

若输出合理文本,说明模型部署成功。

️五、优化与安全加固

1.性能优化技巧

多GPU并行:

使用accelerate库启动多卡推理:

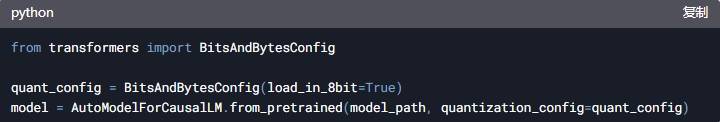

量化压缩:

启用8位量化减少显存占用:

2.安全防护措施

防火墙设置:

仅开放必要端口(如HTTPAPI的5000端口):

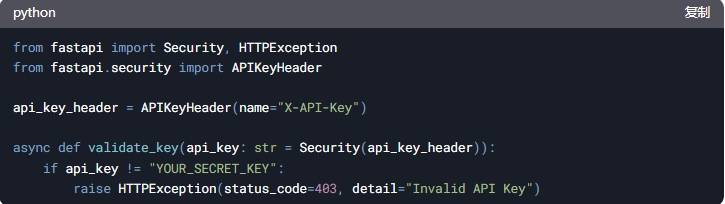

API访问鉴权:

使用FastAPI添加API密钥验证:

️六、总结

通过上述步骤,可以在RAKsmart服务器上部署DeepSeek AI大模型,并实现了基础推理与安全防护。对于企业级应用,可进一步结合Kubernetes实现弹性扩缩容,或使用ONNXRuntime提升推理效率。