手把手教你打造会聊天的AI:DeepSeek微调全攻略

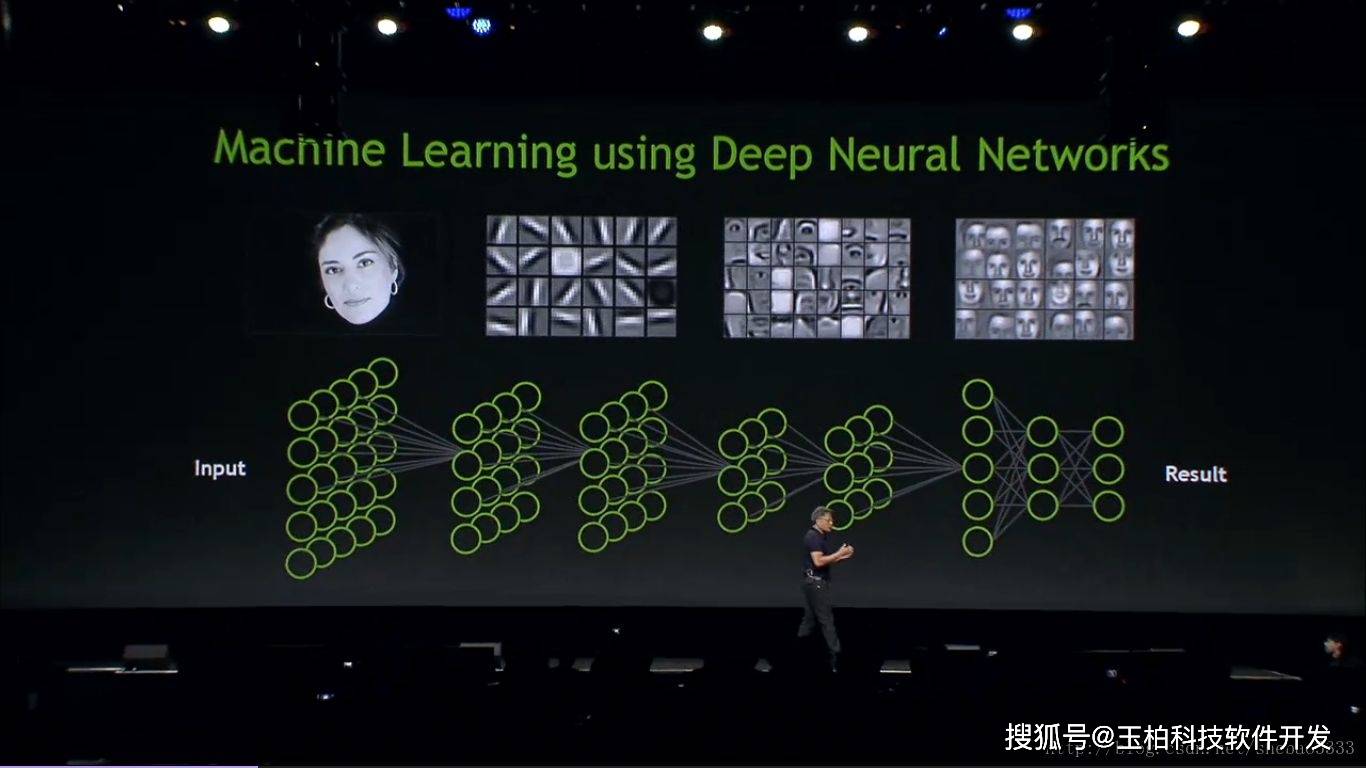

就像给学霸补专业课,微调让通用AI变身领域专家。DeepSeek-7B原本是通识教育的优等生,能回答天文地理却不懂"甄嬛体"。通过LoRA微调技术,我们只需调整0.5%的神经元(约3747万个参数),就能让模型习得特定对话风格。这种技术的神奇之处在于"冻结教学法":保留模型90%的原始认知,仅在注意力机制层(q_proj、v_proj等)插入可训练的"知识插件"。就像在图书馆的书架上添加专题手册,既保留原有藏书,又新增定制内容。

要让AI学会特定话术,需要精心设计训练数据。我们采用"指令-输入-输出"的黄金三角格式:

{ "instruction": "现在你要扮演皇帝身边的女人--甄嬛", "input": "你是谁?", "output": "家父是大理寺少卿甄远道。"}

这种结构化数据如同话剧剧本,明确指导AI在不同场景下的应答策略。当处理3万条单轮对话数据时,代码会将用户提问和标准答案编码成384维的token序列,如同把对话转换成AI能理解的摩尔斯电码。

三、训练现场的"黑科技"在3090显卡上实操时,几个关键技术点决定成败:

- ️梯度累积戏法:通过16步梯度累积,等效实现128的batch_size,显存占用直降70%

- ️注意力掩码魔法:用[-100]屏蔽输入部分的损失计算,确保AI专注学习应答内容

- ️混合精度炼金术:fp16精度下,模型体积缩小50%,训练速度提升2倍

训练日志中的loss曲线如同心电图,当数值从3.2平稳降至0.8时,意味着AI已经掌握对话精髓。全程仅需1小时,耗电量相当于烧开20壶水。

四、从技术到艺术的蜕变微调后的模型展现出惊人变化。当用户问道"为什么总是做不好工作时",原始回答是标准职场建议,而调教后的AI会柔声安慰:"焦虑如同掌心沙,握得越紧流失越快。不妨先深呼吸三次,我们慢慢理清头绪..."在法律咨询场景中,经过500条专业数据微调的模型,能条分缕析地解释"胁迫签约的合同效力",不仅列出《民法典》第150条,还会类比"就像在暴风雨中签订的租船协议"。

五、人人都能玩的AI调教

现在即使只有16G显存的家用电脑,也能驾驭大模型微调。开源社区提供的SwanLab监控平台,让训练过程像看股票走势图一样直观。当你在Colab平台按下启动键,就加入了这场平民化的AI革命。从甄嬛体到法律文书,从医疗诊断到诗词创作,每个垂直领域都在等待专属的AI代言人。这不再是大厂的专利,而是每个有想法的普通人可以触及的未来——毕竟,训练一个会聊天的AI,难度已经低于考取咖啡师资格证。